Robots.txt:

El archivo robots.txt es una herramienta que ayuda a controlar el acceso de los bots de los buscadores a las páginas de un sitio web. Su correcta programación es esencial para una adecuada indexación en Google, lo que mejora el posicionamiento web. Aunque no es infalible, su utilización es una de las prácticas más comunes para la optimización de motores de búsqueda (SEO). En este artículo encontrarás información útil sobre la definición y función del archivo robots.txt, así como consejos para su correcta creación y configuración.

¿Qué es el archivo robots.txt?

El archivo robots.txt es un archivo de texto que se encuentra en la raíz de un sitio web y se utiliza para controlar el acceso de los bots de los motores de búsqueda a las páginas del sitio. A través de este archivo, se pueden establecer comandos para permitir o bloquear el acceso a ciertos archivos o directorios del sitio, indicando, por ejemplo, qué páginas pueden ser rastreadas y cuáles no.

Definición y función del archivo robots.txt

El archivo robots.txt es una herramienta importante para los propietarios de sitios web que desean controlar el rastreo de bots y mejorar el posicionamiento web. Con este archivo, los dueños del sitio pueden permitir o bloquear el acceso a ciertas páginas, ya sea para proteger información confidencial o para evitar problemas con contenidos duplicados. Además, su correcta utilización es esencial para evitar penalizaciones de los motores de búsqueda y para una adecuada indexación de los contenidos en Google.

¿Cómo funciona el archivo robots.txt?

Los bots de los motores de búsqueda analizan el archivo robots.txt antes de rastrear las páginas de un sitio web. En caso de que una página esté prohibida en el archivo robots.txt, el bot no buscará ni indexará esa página. Para configurar adecuadamente el archivo robots.txt, se deben seguir las instrucciones de los motores de búsqueda y tener en cuenta tanto las directivas allow como las directivas disallow. Es importante mencionar que, aunque el archivo robots.txt no bloquea por completo el acceso de las personas a las páginas que contienen las directivas disallow, sí impide que sean rastreadas y mostradas en los motores de búsqueda.

¿Por qué usar robots.txt en tu sitio web?

El archivo robots.txt es una herramienta fundamental para optimizar el posicionamiento SEO de tu sitio web. A continuación, se detallan las principales ventajas de usar este archivo:

Ventajas de utilizar el archivo robots.txt

- Permite controlar el acceso de bots de los motores de búsqueda a las páginas de tu sitio web

- Mejora la indexación de tu sitio web en Google al permitir que los bots rastreen con mayor facilidad las páginas que deseas indexar

- Ayuda a ahorrar recursos del servidor al evitar que los bots rastreen páginas innecesarias o que generan alta carga en el servidor

- Permite bloquear el acceso a páginas que contienen información confidencial o no deseas que sea indexada por los motores de búsqueda

¿Qué pasa si no utilizas el archivo robots.txt?

Si no utilizas el archivo robots.txt, corres el riesgo de que los bots de los motores de búsqueda rastreen páginas no deseadas o innecesarias de tu sitio web. Esto puede generar una carga innecesaria en el servidor y afectar negativamente al posicionamiento SEO de tu sitio web.

Creación y configuración del archivo robots.txt

El archivo robots.txt es una herramienta fundamental para controlar el acceso de los bots a las páginas de tu sitio web. En esta sección se describen las herramientas necesarias para su creación y configuración.

Herramientas para crear el archivo robots.txt

Crear el archivo robots.txt no es complicado de hacer. Para ello, se pueden usar distintas herramientas, como editores de texto, programas específicos o los editores de archivos de los propios servicios de alojamiento de la web. Algunos de estos últimos, suelen ofrecer plantillas que facilitan la creación del archivo robots.txt.

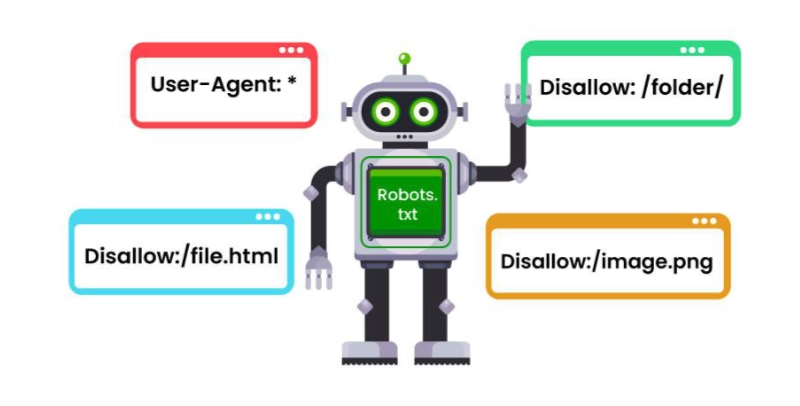

Instrucciones básicas del archivo robots.txt

El archivo robots.txt consta de unas instrucciones básicas que son necesarias para su correcta utilización. Estas son las siguientes:

- User-agent: Indica el bot de búsqueda que deseas controlar. Por ejemplo, Googlebot

- Disallow: Establece las páginas que no quieres que se indexen

- Allow: Indica las páginas o carpetas permitidas a rastrear

- Sitemap: Define la ubicación del sitemap

Para que las herramientas de búsqueda entiendan estas instrucciones, se debe crear el archivo robots.txt en el directorio principal de tu sitio web.

Uso de comandos Allow y Disallow

Los comandos Allow y Disallow se utilizan para establecer los permisos de las páginas a las herramientas de búsqueda. Por ejemplo, si no queremos que una página se indexe por Google, utilizaremos el comando Disallow seguido de la URL de esa página en el archivo robots.txt.

- Disallow: /ejemplo.html

- Disallow: /ejemplo/

- Disallow: /ejemplo˜2023/

- Allow: /ejemplo2.html

En este ejemplo, se especifica que se prohíbe el acceso a «/ejemplo.html», a «/ejemplo/» y a «/ejemplo˜2023/» por el bot de Google. Sin embargo, se permite el acceso a «/ejemplo2.html».

Ejemplos prácticos del archivo robots.txt

El archivo robots.txt es una herramienta muy útil para el SEO y la indexación de tu sitio web. A continuación, se presentan algunos ejemplos prácticos del archivo robots.txt:

Crear un archivo robots.txt para bloquear una página web

Si deseas bloquear una página web en tu sitio, puedes hacerlo utilizando el archivo robots.txt. Para ello, debes agregar la instrucción “Disallow” seguida del URL de la página que deseas bloquear

- Agrega la línea “User-agent: *” Al principio del archivo robots.txt. Esto asegurará que la instrucción sea interpretada por todos los bots.

- Agrega la línea “Disallow: /ejemplo.html” para bloquear la página “ejemplo.html”.

- Guarda el archivo como “robots.txt” y súbelo a la raíz de tu sitio web.

Evitar que los rastreadores de búsqueda indexen archivos de imágenes y videos

Algunas veces, es conveniente evitar que los bots indexen ciertos tipos de archivos, como imágenes o videos. Para hacer esto, debes agregar la instrucción “Disallow” seguida de las extensiones de archivo que deseas bloquear:

- Agrega la línea “User-agent: *” Al principio del archivo robots.txt.

- Agrega la línea “Disallow: /*.jpg$” para bloquear las imágenes en formato JPG.

- Agrega la línea “Disallow: /*.mp4$” para bloquear los videos en formato MP4.

- Guarda el archivo como “robots.txt” y súbelo a la raíz de tu sitio web.

Consejos y recomendaciones para la creación del archivo robots.txt

Para aprovechar al máximo el archivo robots.txt, es importante seguir algunas recomendaciones:

- No bloquees páginas importantes: Asegúrate de que las páginas más importantes de tu sitio sean accesibles para los bots.

- No bloquees recursos importantes: Como se mencionó anteriormente, el archivo robots.txt no puede bloquear recursos como imágenes o videos. Para bloquearlos, debes utilizar otras técnicas.

- No agregues rutas innecesarias: Agregar rutas innecesarias al archivo robots.txt puede dificultar la indexación de tu sitio.

- Verifica el archivo antes de subirlo: Es importante verificar el archivo antes de subirlo a tu sitio web para asegurarte de que no haya errores de sintaxis.

Importancia de seguir las instrucciones adecuadas

Es fundamental seguir las instrucciones adecuadas al crear el archivo robots.txt en nuestro sitio web, ya que una mala configuración puede generar consecuencias no deseadas en la indexación de nuestro contenido. En este sentido, es recomendable seguir los siguientes consejos:

Saber qué se debe bloquear

Es importante saber qué secciones deseamos bloquear para evitar que ciertas páginas indeseadas sean indexadas en Google o cualquier otro motor de búsqueda. Asegúrate de incluir la URL de las páginas en el archivo robots.txt.

Utilizar los comandos correctos

Es recomendable utilizar correctamente los comandos allow y disallow, ya que estos permitirán o bloquearán la indexación de ciertas páginas. Además, es necesario conocer cuál es la función de cada comando y cómo deben ser utilizados en conjunto para lograr una correcta indexación.

Verificar el archivo robots.txt

Una vez creado el archivo, es importante verificarlo para confirmar que se han implementado las instrucciones adecuadas. Para hacerlo, se pueden utilizar herramientas disponibles en línea que permiten detectar posibles errores en nuestro archivo.

Actualizar el archivo con frecuencia

Es importante actualizar el archivo robots.txt con frecuencia, especialmente si hemos agregado o eliminado páginas de nuestro sitio web. Esto permitirá que los motores de búsqueda indexen el contenido actualizado y garanticen una correcta indexación.

Consultar con un experto

En caso de tener dudas, es recomendable consultar con un experto en SEO o marketing digital que pueda brindar asesoría sobre cómo crear y configurar el archivo robots.txt. Para garantizar una adecuada indexación en Google y otros motores de búsqueda, es importante seguir estos consejos y recomendaciones al crear y configurar el archivo robots.txt.